Ces travaux pourraient enfin faire passer les réseaux neuronaux analogiques à la vitesse supérieure.

Le cerveau humain est une véritable merveille d’évolution et de sélection naturelle dont l’immense complexité nous échappe encore très largement. Mais cela n’empêche pas les chercheurs de travailler sur des techniques basées sur des principes comparables ; par exemple, tout le monde a déjà entendu parler des réseaux neuronaux.

Lorsqu’on réfléchit à ces systèmes aujourd’hui très importants dans le domaine de l’intelligence artificielle, on pense surtout à des algorithmes. Pourtant, la définition du réseau neuronal est strictement fonctionnelle ; peu importe la forme qu’il prend, ce qui importe, c’est la façon dont il traite les informations.

Un réseau de neurones analogique

Très sommairement, ce terme désigne tout un tas de systèmes dont le fonctionnement s’inspire directement de l’architecture cérébrale, avec ses sous-unités logiques — les neurones — reliées par des synapses.

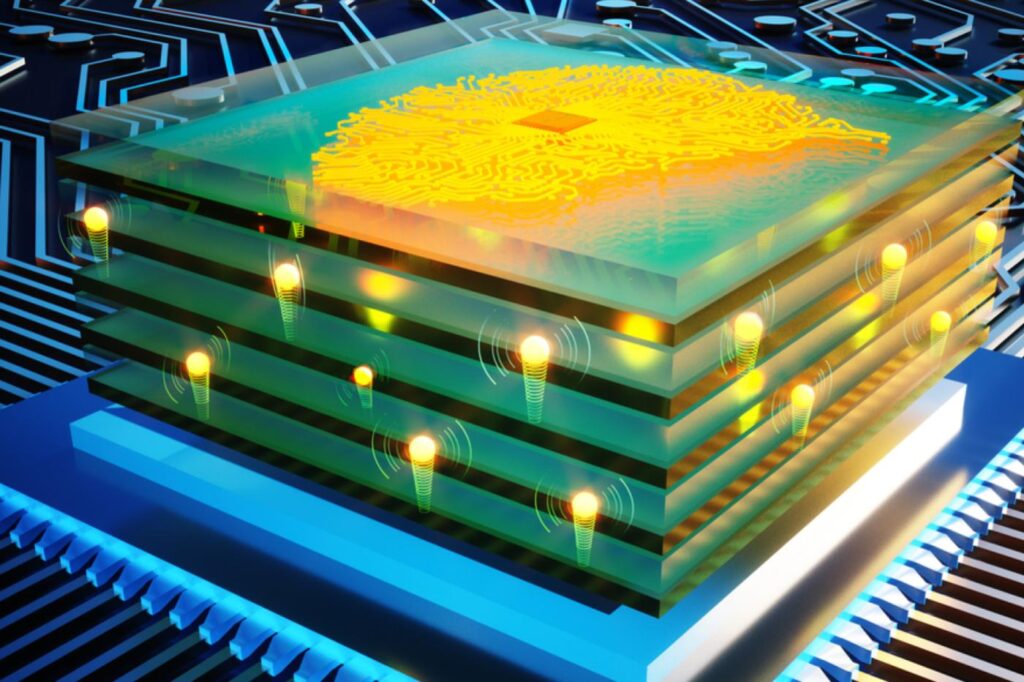

Cela signifie que ces réseaux neuronaux peuvent tout à fait exister physiquement. Sans rentrer dans le détail, ils fonctionnent alors sur des bases analogiques, par opposition au mode numérique. On parle alors de réseau de neurones analogique (ou ANN). C’est une approche encore assez balbutiante. Mais de nombreux travaux ont déjà suggéré qu’il pourrait s’agir d’une piste très intéressante pour la recherche en IA.

Sur le papier, ces ANN présentent des avantages considérables. Puisqu’ils reposent sur une structure physique, et non pas exclusivement virtuelle, ils sont immensément plus économes en énergie. Ils peuvent aussi être entraînés et fonctionner à des vitesses très largement supérieures aux réseaux numériques. Les informations y sont en effet traitées en parallèle ; cela signifie qu’on peut augmenter le nombre de sous-unités logiques sans ralentir les calculs, puisque les informations ne doivent pas transiter en permanence entre la mémoire et le processeur.

Ce papier de recherche explique aussi que ce concept est beaucoup plus pratique lorsqu’il s’agit de concevoir une interface entre l’IA et le monde réel, ce qui est très important pour les applications concrètes de cette technologie.

“Presque de la téléportation”

Le problème, c’est que ces avancées restent encore suspendues à l’exploration de nouveaux matériaux et techniques de production ; pour rivaliser avec les algorithmes, il faut en effet concevoir un système extrêmement rapide.

Et tout récemment, l’équipe de Murat Onen, chercheur au prestigieux MIT, a justement présenté des travaux qui promettent de faire passer ce concept à la vitesse supérieure — littéralement, puisqu’ils ont conçu une synapse artificielle un million de fois plus rapide que celles du cerveau humain.

Pour y parvenir, ils se sont basés sur un matériau inorganique aux propriétés très intéressantes, le verre de phosphosilicate inorganique (ou PSG). C’est un matériau dérivé du silicium qui est constellé de minuscules pores. Habituellement, il est utilisé pour protéger des meubles de l’humidité. Mais les chercheurs ont exploité une autre de ses propriétés, à savoir sa capacité à encaisser des tensions électriques très importantes sans broncher.

Les chercheurs ont donc pu s’en servir pour produire une synapse artificielle ultra-performante. Les particules peuvent y voyager à une vitesse affolante. « Normalement, nous ne pourrions pas appliquer des champs aussi importants à un appareil sous peine de le réduire en cendres », explique Onen. « Mais à la place, les protons ont fini par voyager à une vitesse immense, sans endommager quoi que ce soit », et à température ambiante. « C’est presque de la téléportation », souffle-t-il, visiblement bluffé.

Une preuve de concept déterminante pour l’IA du futur ?

Ce progrès leur a permis de construire un réseau neuronal analogique extrêmement rapide, et capable d’opérer « à des voltages raisonnables ». C’est la toute première fois qu’une équipe parvient à démontrer la faisabilité concrète d’un ANN aussi performant. Et cette étude pourrait donc se révéler importante pour le futur de l’IA; elle a en tout cas le potentiel pour ouvrir la porte à une toute nouvelle génération d’appareils physiques spécifiquement conçus pour ces applications.

« Ces travaux ont amené ces appareils à un point où ils commencent à devenir très prometteurs pour des applications futures », se réjouit Jesús A. del Alamo, l’un des auteurs de l’étude. William Chuech, un professeur en science des matériaux à la célèbre université Stanford partage en tout cas cette interprétation, même s’il n’a pas participé aux travaux. « Cela pose les fondations d’une nouvelle classe d’appareils pour alimenter les algorithmes de deep learning », affirme-t-il.

« Avec un processeur analogique, nous entraînerons des réseaux neuronaux à la complexité sans précédent que personne ne peut se permettre d’entraîner aujourd’hui », conclut Onen. Un véritable changement de paradigme potentiel, donc. Il considère qu’il s’agirait d’une avancée absolument majeure, un peu comme le fait de passer de la simple « voiture » au véritable « vaisseau spatial ».

Désormais, il ne reste plus qu’à affiner le concept pour commencer à envisager des applications à l’échelle industrielle qui pourraient à leur tout participer à l’émergence d’une toute nouvelle génération d’ordinateurs analogiques.

jdg